Las Inteligencias Artificiales Generativas han sido el último boom tecnológico de los últimos dos años. Con ChatGPT a la cabeza, acompañado de otras IAs especializadas en generación de imágenes como Stable Diffusion, Midjourney o Adobe Firefly entre muchas otras, Apple simplemente ha permanecido ajena a todo esto por una simple razón; No se lo esperaban. Por esa razón, en el equipo ejecutivo se toman esta tecnología como algo preocupante y un aspecto tecnológico en el que van claramente por detrás de la competencia.

Lo curioso es que hay mucha tecnología basada en el machine learning en iOS y los procesadores que Apple utiliza en el iPhone, iPad o Macs son los mejores preparados del mercado para estas tareas gracias a su motor neuronal, una parte del procesador especializada en tareas de machine learning especialmente rápida a la hora tratar redes neuronales, que es lo que hay detrás de todos estos modelos de lenguaje masivos como ChatGPT, las mal llamadas IAs generativas etc. iOS utiliza esta parte del chip en sus tareas de reconocimiento de imagen, de búsqueda semántica en el carrete de fotos ya incluso en el año 2016, de textos, en el sistema de predicción del teclado virtual, el sistema que identifica a una persona en una foto o vídeo, el sistema que permite recortar un sujeto en una imagen para convertirlo en una pegatina para Apps de chat, en el reconocimiento de voz del dictado, con Siri… es algo muy utilizado en muchas tareas, sin que los usuarios lo sepan. Esto es así porque las redes neuronales y el machine learning son muy útiles y versátiles en muchas tareas. Sin embargo, con los modelos más avanzados de generación de imagen y de chat, Apple no ha estado presente porque simplemente no se esperaban esta explosión tecnológica en este campo, a pesar de haber estado trabajando en aspectos muy relacionados.

Todo esta preocupación interna por haber quedado detrás en el comienzo de estas tecnologías, nos la cuenta Mark Gurman en su newsletter PowerOn de este fin de semana. Nos dice que John Giannandrea y Craig Federighi están ahora a la cabeza de un esfuerzo por ponerse al día e integrar modelos generativos de imágenes en Xcode a la manera en la que Microsoft ha añadido Copilot para ayudar a programadores a programar sus Apps. Las aplicaciones ofimáticas de Apple, como Pages, Numbers etc también podrían recibir la ayuda de estos modelos para generar contenidos como presentaciones bonitas basadas en una petición o ciertos parámetros, por ejemplo, como ya hace Microsoft también con su suite ofimática. Eddy Cue está a la cabeza de estos esfuerzos.

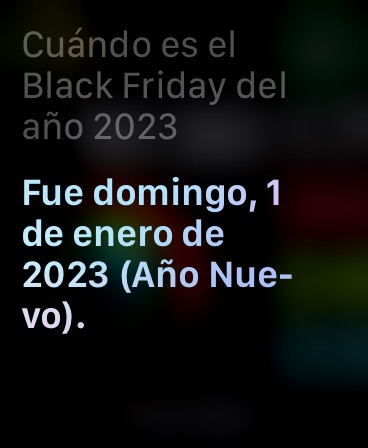

Uno de los objetivos de Giannandrea es, de hecho, poder utilizar estos nuevos modelos masivos de aprendizaje artificial para mejorar el asistente de Apple, Siri, que a menudo en el año 2023 sigue siendo más tonto que un lápiz. Como prueba, tenemos esta imagen de Siri contestando que Black Friday en el 2023 tuvo lugar en el mes de enero, cuando estamos a unas cinco semanas vista de esos días en este año, a finales de noviembre. Es una pregunta básica, sencilla, que no debería haber ningún problema en contestar. Pero Siri simplemente no puede con ella. A estas alturas, es realmente muy WTF que sigamos teniendo estas lagunas en el asistente de Apple.

Viendo estos resultados no sorprende en absoluto que dentro de Apple estén preocupados con el avance que en este tipo de tecnologías están teniendo empresas como OpenAI, Microsoft, Adobe etc. El nombre de Apple no aparece en la lista a día de hoy. Ojalá que esto cambie en el futuro.