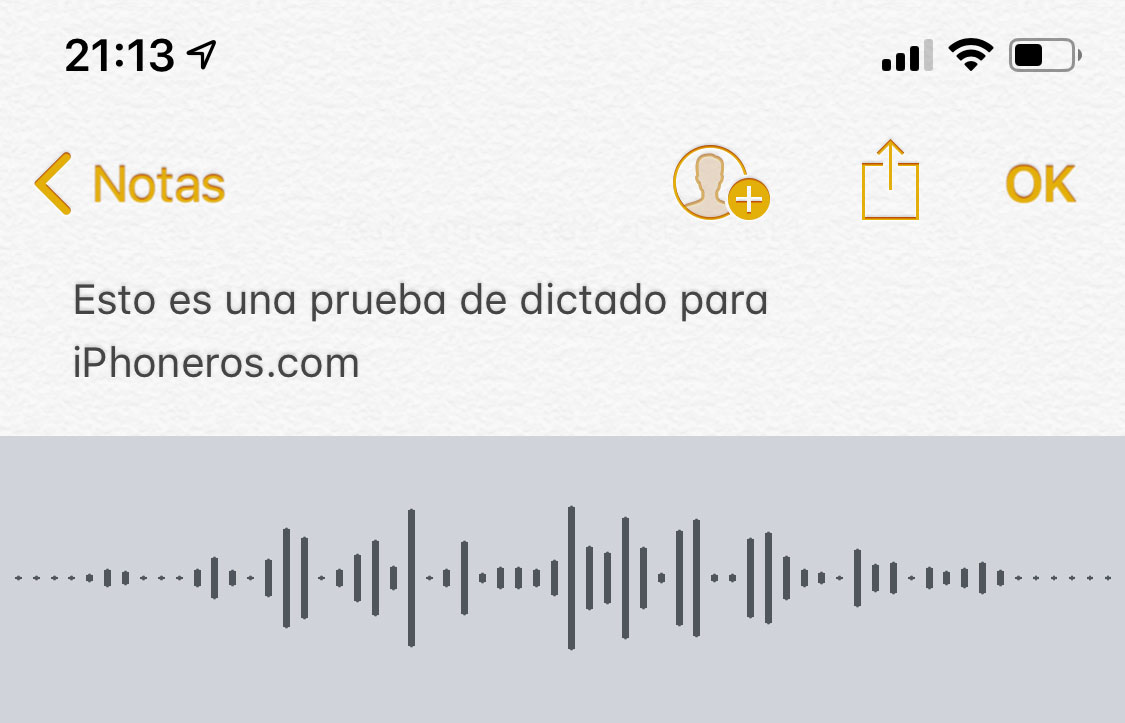

Después de toda la polémica que han provocado las escuchas de Google Assistant inicialmente, Apple tomó la decisión de incluir una opción que permitirá a los usuarios garantizar que su voz nunca será escuchada por ninguna persona incluso si está totalmente anonimizada, es decir, desprovista de cualquier dato que pueda identificar al usuario que lo dijo. Esto, sin embargo, no evitará que lo que decimos sea potencialmente revisado, aunque de otra manera, por una persona que confirme si el sistema está funcionando como debe, y si no es así, lo corrija. Es parte del proceso de machine learning o grading, que permite mejorar las respuestas de Siri o la calidad de las transcripciones de lo que dictamos al sistema de reconocimiento de voz cuando queremos teclear algo en cualquier App y no tenemos tiempo de mirar al teclado, o porque simplemente es muy rápido y cómodo. La verdad, es que funciona bastante bien.

Apple ha publicado hoy un documento de soporte en el que indica que efectivamente no permitirá que las grabaciones de audio de los usuarios sean escuchadas por nadie si el usuario activa esa opción (opt-in), pero lo que sí hará es utilizar las transcripciones de ese audio.

Si te preguntas qué es una transcripción exactamente, se trata simplemente de la conversión de lo que uno dice a texto. Así, nadie escuchará lo que le decimos a Siri o el sistema de dictado (que son en realidad el mismo sistema), pero sí que es posible que alguna persona lea esa transcripción con el objetivo de corregir al sistema si ésta no fuera correcta, y así, mejorar el porcentaje de transcripciones correctas que se hacen con el paso del tiempo. Esto se hace así que es la única manera de conseguir que un sistema de este tipo mejore y funcione cada vez mejor. Estas transcripciones se conservan durante un período de seis meses, y de ninguna manera es posible determinar quién dijo eso tiempo atrás, ya que sólo se pueden identificar con un número que es asignado al azar, y no hay ninguna otra identificación ni de usuario ni de dispositivo. Los audios, a partir de iOS 13, no se van a guardar de ninguna manera si no has activado la opción correspondiente en la App de Ajustes para ayudar a Apple a mejorar el sistema. Esto es algo que han dado a conocer hoy en una nota de prensa, en la que además piden disculpas por no haberlo dejado más claro con anterioridad.

Si esto no te parece bien, la única manera de evitar que ocurra será desactivar Siri en tu iPhone, iPad, iPod touch, Apple Watch, Apple TV o Mac… simplemente apagarlo para que no pueda grabar nada, y por lo tanto, no quede ningún texto transcrito.

En el caso de que no te importe y aceptes incluso que escuchen tus audios, debidamente anonimizados, Apple indica que está trabajando para quitar incluso cualquier otro indicio que haya y que permita identificar a un usuario por su voz. Por ejemplo, si el usuario ha interactuado con Siri para controlar algún dispositivo compatible con Home como apagar o encender la luz, el nombre de ese dispositivo aparece, pero si no lo hace, el nombre no está disponible tampoco. A menudo, los usuarios ponen nombres a estos dispositivos que identifican, por ejemplo, si están en un dormitorio o en un salón. Esta información también será borrada.

Está claro que Apple está haciendo esfuerzos por mejorar esta situación sin tener que dejar de ofrecer el servicio de asistente virtual de Siri, pero aún así bastantes usuarios están preocupados por si alguno de sus audios aparece en ese 0,2% que se escuchan por personas encargadas de ese grading para confirmar que la respuesta y transcripción es correcta y, si no lo fuera, corregirla.