En agosto del año 2021 Apple anunció un nuevo sistema automático y totalmente privado que comprobaría el contenido de ciertas imágenes de abuso infantil para reportarlas si encontraba un elevado número de coincidencias de las mismas en la misma cuenta de Apple, a través de las fotos y vídeos almacenados en iCloud. El sistema funciona de tal manera que comprueba si una imagen es la misma que existe en una base de datos de este tipo de deleznables imágenes de abusos infantiles, y si esto ocurre muchas veces en la misma cuenta, una persona verifica entonces que efectivamente son esas imágenes. Sólo entonces, la comprobación pasa a ser manual porque aunque un número elevado de falsos positivos de este sistema es extremadamente poco probable, nunca se puede dejar de tener en cuenta esa posibilidad ante una acusación tan grave. Este sistema se llama CSAM y es realmente inteligente.

Sin embargo, este sistema puso en pie a muchos usuarios y organizaciones que acusaron a Apple de espiar a sus clientes, en la mayoría de ocasiones sin entender cómo funciona este sistema realmente, mediante un algoritmo matemático que no incluye en ningún momento ningún tipo de reconocimiento de imagen. Es increíblemente respetuoso con la privacidad de los usuarios, e intenta solucionar un problema gravísimo que es la lacra de las personas que buscan imágenes de abusos infantiles porque son enfermos mentales. Apple, desde su posición, tiene la posibilidad de detectar a estas personas y hacer algo al respecto, para que esas imágenes y también los abusos no puedan utilizar iCloud como medio de difusión.

Por esta razón, Apple decidió dar marcha atrás, para re-evaluar la situación hasta el punto de llegar a parar el proyecto completamente. Esto ha causado que una organización que invierte millones de dólares en fomentar la instalación de este tipo de sistemas de verificación para conseguir reducir la distribución de imágenes de abusos infantiles, acuse a Apple directamente de permitir que iCloud se utilice para este fin tan maligno.

En esa campaña, han publicado esta web en donde directamente atacan a Apple para intentar que cambien de parecer y finalmente implementen el sistema CSAM que prometieron y ayuden a detener la distribución de imágenes de abusos infantiles.

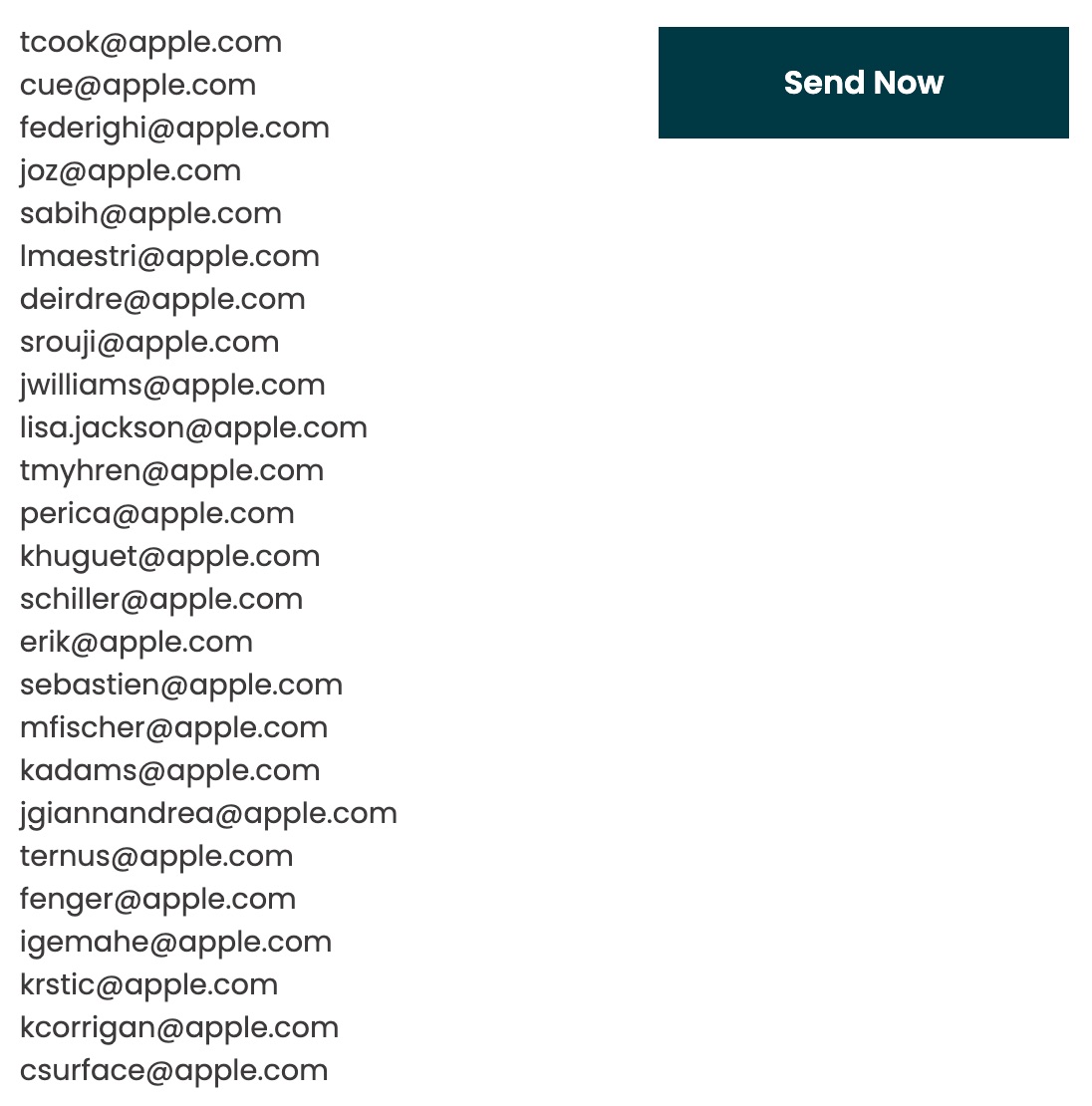

En esta web hay un botón para enviar un email a toda la junta directiva de Apple desde un formulario de contacto, en el que piden expresamente a Apple que implementen el sistema CSAM prometido. Aparece la lista completa de direcciones de email de la junta directiva de Apple.

Desde luego este asunto es bastante polémico y muchas personas están tanto a favor como en contra, pero lo que realmente molesta más de todo esto es que la mayoría de usuarios no comprenden bien cómo funciona, cómo es posible encontrar imágenes de este tipo sin romper la privacidad máxima del usuario. Si alguien que conoce realmente cómo funciona y entiende lo increíblemente poco probable que es que algo funcione mal decide no apoyar el sistema, de acuerdo. Pero lo realmente triste es que tan pronto se menciona la detección de imágenes prohibidas en iCloud, saltan las alarmas de vigilancia inaceptable, Edward Snowden vuelve a abrir la boca para promover el miedo hacia esta función, y tildan a Apple de no proteger la privacidad de sus usuarios. Lo cierto, es que hay usuarios de Apple que lamentablemente se aprovechan de ella para hacer daño a niños que en muchos casos se quedarán con una secuela insuperable de por vida, y eso, es lo realmente inaceptable. Snowden tiene dos hijos, uno nacido en el 2020 y otro en el 2022, así que quizás algún día cambie de opinión.