Tal y como se rumoreaba unas horas antes, Apple ha publicado una página en su web en la que da a conocer que en el futuro cercano, todas las nuestras fotos serán comprobadas en búsqueda de ciertas imágenes, ya conocidas, de abusos a menores.

Ahora, sabemos con detalle las dos iniciativas que Apple está implementando en torno a esta nueva funcionalidad, sin que por ello la privacidad de los usuarios se vea afectada, o al menos, la de los usuarios que no poseen fotografías de ese tipo, que es la idea detrás de todo esto.

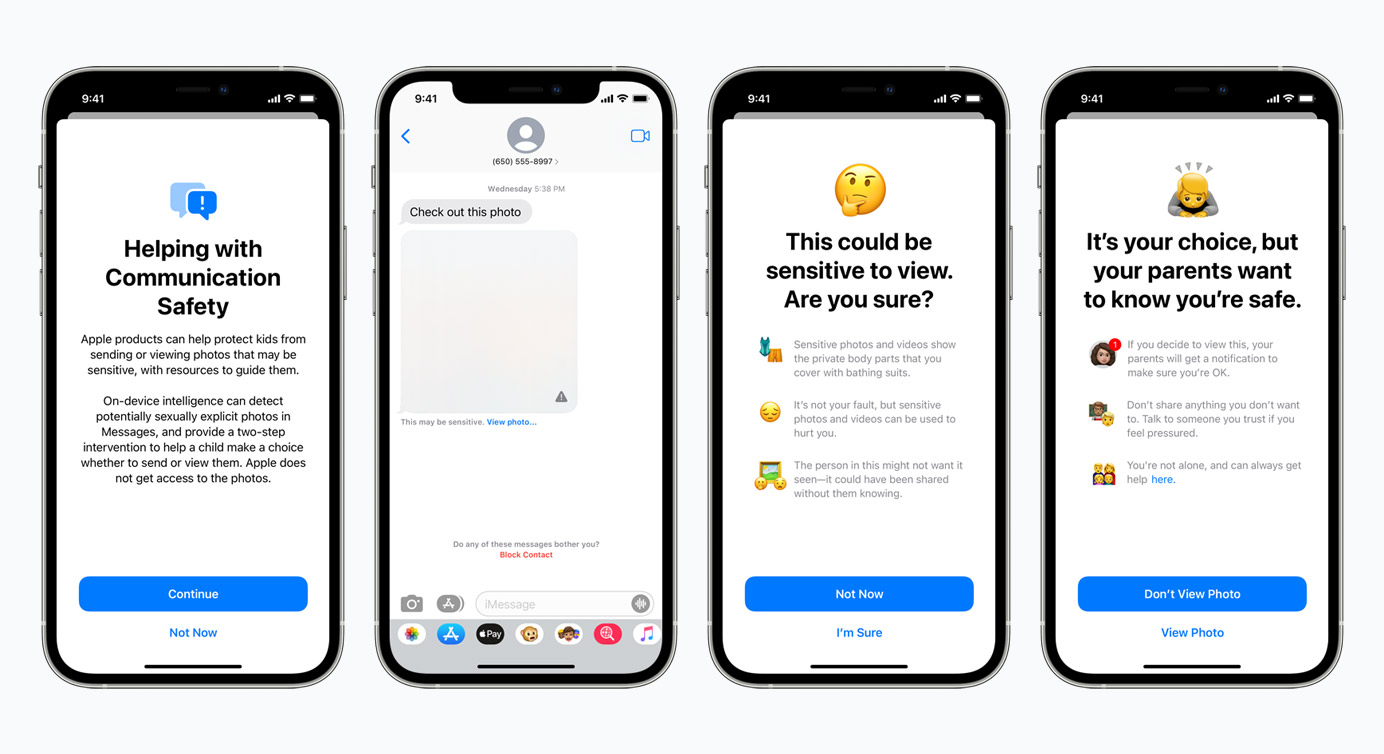

La primera, es un sistema de alerta en la App de Mensajes que avisa a los usuarios de iPhone que tienen una cuenta infantil de Apple, es decir, administrada por sus padres, cuando se detectan fotos en las que hay personas sin ropa, tanto al enviar, como al recibir. Esas imágenes aparecerán censuradas y aparecerán mensajes como los que ves sobre estas palabras alertando al menor. Si el menor acepta ver la imagen de todas maneras, se informa que sus padres recibirán una notificación de que la imagen ha sido visualizada, para que puedan tomar las medidas oportunas.

Esta funcionalidad sólo afecta a cuentas administradas por padres, marcadas como para menores de edad, y afecta sólo a la App de Mensajes, que en EEUU es mucho más utilizada que en España y otros países, en donde WhatsApp y otras Apps de mensajería instantánea todavía son mucho más utilizadas, comparativamente hablando. Esas Apps continuarán funcionando como hasta ahora, y si algún día cambia eso, será porque sus desarrolladores así lo han programado.

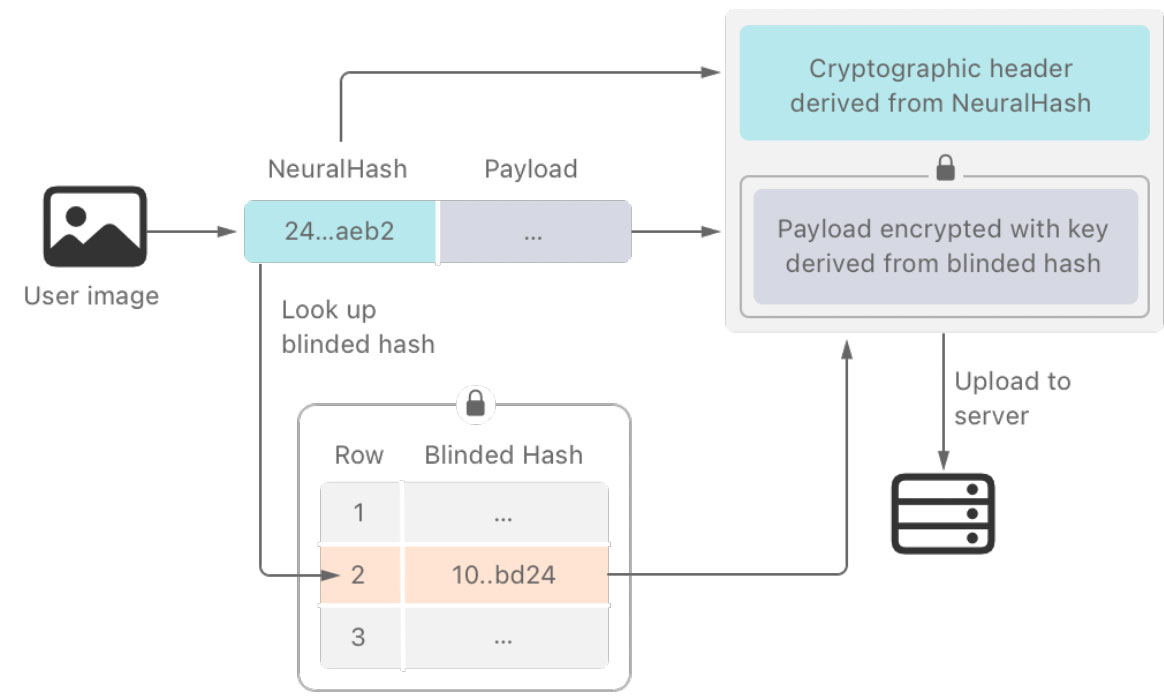

La segunda iniciativa, es la que os contamos hace unas horas; Todas las fotos se comprobarán con un sistema de reconocimiento de imágenes que detectará si se trata de explotación o abuso de menores. El sistema funciona íntegramente en el iPhone, mediante un sistema de hash. Un hash no es más que un largo código alfanumérico, que se crea para identificar una imagen entre todas las demás. Con un sistema matemático, cada imagen tiene un código asociado, que es único para esa foto. Ese hash se compara después con los hash de fotos de abusos de menores que se conocen, y si coinciden, se puede determinar que se trata de la misma imagen. Si en un iPhone hay una colección de imágenes que coinciden, se sabe que esa persona está en posesión de un material ilegal, y eso ya supone un delito por sí mismo, por lo que en el lado de Apple sonarán las alarmas para identificar y avisar sobre las fotos de esa persona a las autoridades competentes en cada país. Estos códigos, permiten identificar una imagen aunque no sean idénticos, pero sí muy parecidos, como por ejemplo asociar la misma imagen en color o en blanco y negro, o sólo una porción de la misma. Llaman a este sistema que asocia diferentes versiones de la misma imagen NeuralHash.

Apple dice en la página donde explica todo este proceso que el margen de error que da lugar a falsos positivos no es cero, pero sí es extremadamente pequeño. Para una imagen, es de un sólo error cada millón de millones de comprobaciones. Además de eso, las alarmas no suenan por una imagen, o dos, sino por un buen número de ellas. El sistema busca colecciones de imágenes, no un sólo caso, aunque Apple no especifica de cuántos positivos se trata para superar ese umbral que da la alarma. En cualquier caso, aseguran que es extremadamente improbable que una persona sea señalada por error por este sistema, al mismo tiempo que es muy probable que alguien en posesión de varias de estas imágenes ilegales, sea encontrada con relativa facilidad.

Esta comprobación se hace en el iPhone antes de que las imágenes sean subidas a la copia de seguridad de iCloud.

Apple ofrece toda la explicación técnica de cómo funciona este sistema en este fichero PDF.

Todo esto, probablemente dará mucho que hablar en futuros meses, y a pesar de que nadie quiere que los enfermos que quieren conseguir imágenes de este tipo no sean encontrados, tener un sistema de reconocimiento de este tipo en funcionamiento lo queramos o no, hará que muchos acusen a Apple de Gran Hermano, de vigilante, de falta de privacidad etc. Sin duda va a ser una funcionalidad que causará muchísima repercusión social. Muchos de los que se oponen a estos sistemas alegarán que hoy se busca por fotos de abusos con niños, pero, ¿quién garantiza que en el futuro no se busquen imágenes de cualquier otra cosa o que este sistema no se utilice de manera incorrecta? – Por ejemplo, dos adultos que, con consentimiento mutuo, comparten imágenes privadas o comprometedoras, propias o de otros adultos. Viendo que estos sistemas están en funcionamiento es para pensarse más de dos veces hacer cosas así. No habrá una persona detrás comprobando nada, ni en Apple ni en ningún lado, y el sistema de reconocimiento de imagen no va a levantar hoy en día ninguna alarma por fotos o vídeos así, pero el criterio que hoy se limita sólo a fotos de menores de edad, podría cambiar en el futuro.

Este sistema entrará en funcionamiento con iOS 15, por ahora sólo en EEUU, aunque se extenderá al resto de territorios pronto. El sistema no funciona si la opción de subida de fotos a iCloud está desactivada.