Con iOS 12, Apple ha actualizado también sus mapas para incluir mucho más detalles y datos de localizaciones de los que hasta ahora carecían. Es una actualización que ellos mismos han llamado de calidad, utilizando las furgonetas con sensores que hemos visto en el pasado circulando por calles norteamericanas.

Con los sensores LIDAR que tienen estos vehículos, Apple ha conseguido darle mucho más detalle al contorno 3D de algunos edificios, pero la mejora más importante de sus mapas no ha venido de estas furgonetas sino de las imágenes satelitales, gracias a las cuales han añadido muchos más detalles de la vegetación, haciendo que muchas localidades californianas tengan ahora un aspecto más verde.

Haciendo zoom sobre una localidad concreta, podemos ver que ahora los ríos, los caminos en el campo, los bosques etc tienen todos mucho más detalle que antes… o directamente existen, cuando antes no se veía nada.

En este sentido, se podría decir que los mapas de Apple ofrecen ahora mucho más detalle en cuanto a la naturaleza que los mapas de Google y el resto de proveedores de mapas. Comparativamente, la diferencia es muy clara;

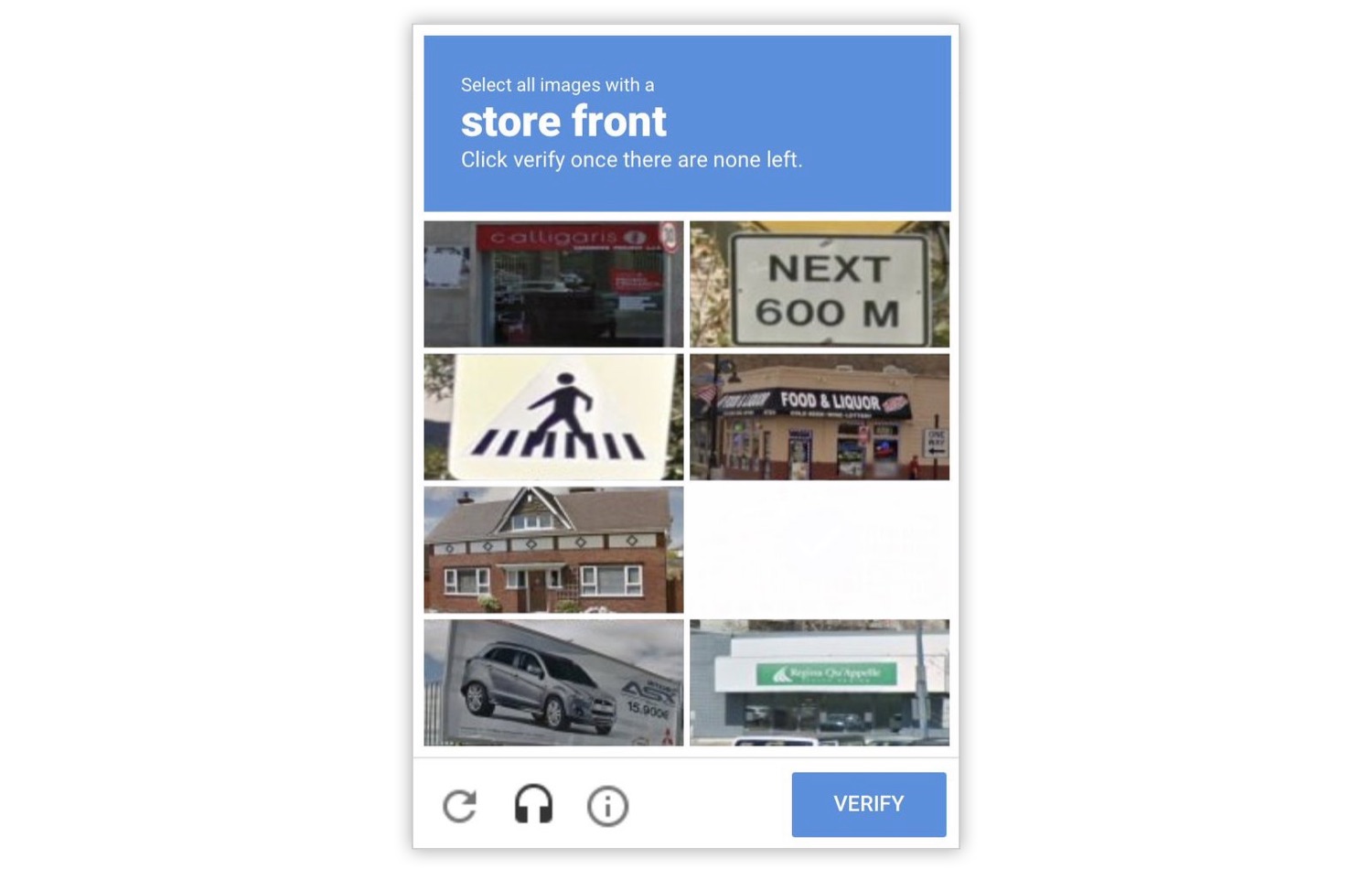

En el punto en el que Apple todavía tiene que mejorar, es el de poner nombre a los establecimientos, las tiendas que hay en las calles. A veces, la etiqueta aparece varias decenas de metros desplazada, y en otras ocasiones la etiqueta que sale en un edificio es simplemente errónea. Apple consigue estos datos de Yelp, y si Yelp no lo tiene, ellos tampoco. Esos datos de Yelp, a día de hoy, no son tan exactos y buenos como sí son los de Google Maps. Es un aspecto en el que Apple todavía tiene que trabajar mucho en los próximos años. Según parece, los nombres de las tiendas podrían extraerse utilizando un sistema de reconocimiento de imágenes, usando esas fotos y vídeos que los vehículos de Apple toman cuando pasan por una calle. Así es como lo hace Google, y lo hace muy bien, sobre todo gracias a la ayuda de todos esos captchas que nos hacen completar al intentar entrar en muchos servicios online. Es una manera de entrenar al sistema de inteligencia artificial de Google especializado en esta tarea, al mismo tiempo que se consigue evitar el problema de los bots que intentan hurtar cuentas de acceso de cualquier web intentando muchas contraseñas diferentes listadas en un diccionario.

Google tiene además la versión web de sus mapas, utilizada por muchos millones de personas en todo el mundo, mientras que los mapas de Apple sólo se pueden utilizar en sus dispositivos, nunca en la web. Google tiene así a muchísimas personas reportando problemas de datos incorrectos en sus mapas, mientras que Apple está limitada a los usuarios que reportan problemas desde un iPhone, iPad o Mac. Esa es una enorme limitación. Al mismo tiempo, Google puede saber dónde empieza y acaba un viaje o quién entra a una tienda, y así, determinar nuevas rutas, tiempos de trayecto, frecuencia de atascos, popularidad de un establecimiento, horarios de apertura… son muchísimos datos con los que enriquecer sus mapas, a los que Apple, deliberadamente, no tiene acceso. Esto hace que las mejoras de sus mapas se extiendan en el tiempo enormemente.

En cualquier caso, lo realmente frustrante para muchos usuarios dei Phone de toda esta situación con los mapas de Apple es que esta mejora que han aplicado a la calidad de sus datos geográficos sólo se aplica en un pequeño porcentaje de sus mapas, concretamente 3,1% de los EEUU de Norteamérica.

Fuera de EEUU, por ahora no parece que esté ni siquiera en los planes. Es precisamente fuera de EEUU en donde los mapas de Google resultan ser infinitamente mejores que los de Apple en prácticamente cualquier aspecto… y la razón por la que llevamos años recomendando utilizar Apple Maps si no vives en San Francisco y alrededores.

En este detalladísimo artículo de Justin O’beirne puedes comprobar muchos otros detalles de cómo los datos de los mapas de Apple en California pueden ser a veces mejor que los de Google, y en muchas ocasiones, peor. También explica cómo podrían estar obteniendo esos datos, si utilizan algoritmos de reconocimiento de imagen o a un ejército de personas actualizando esos datos manualmente.