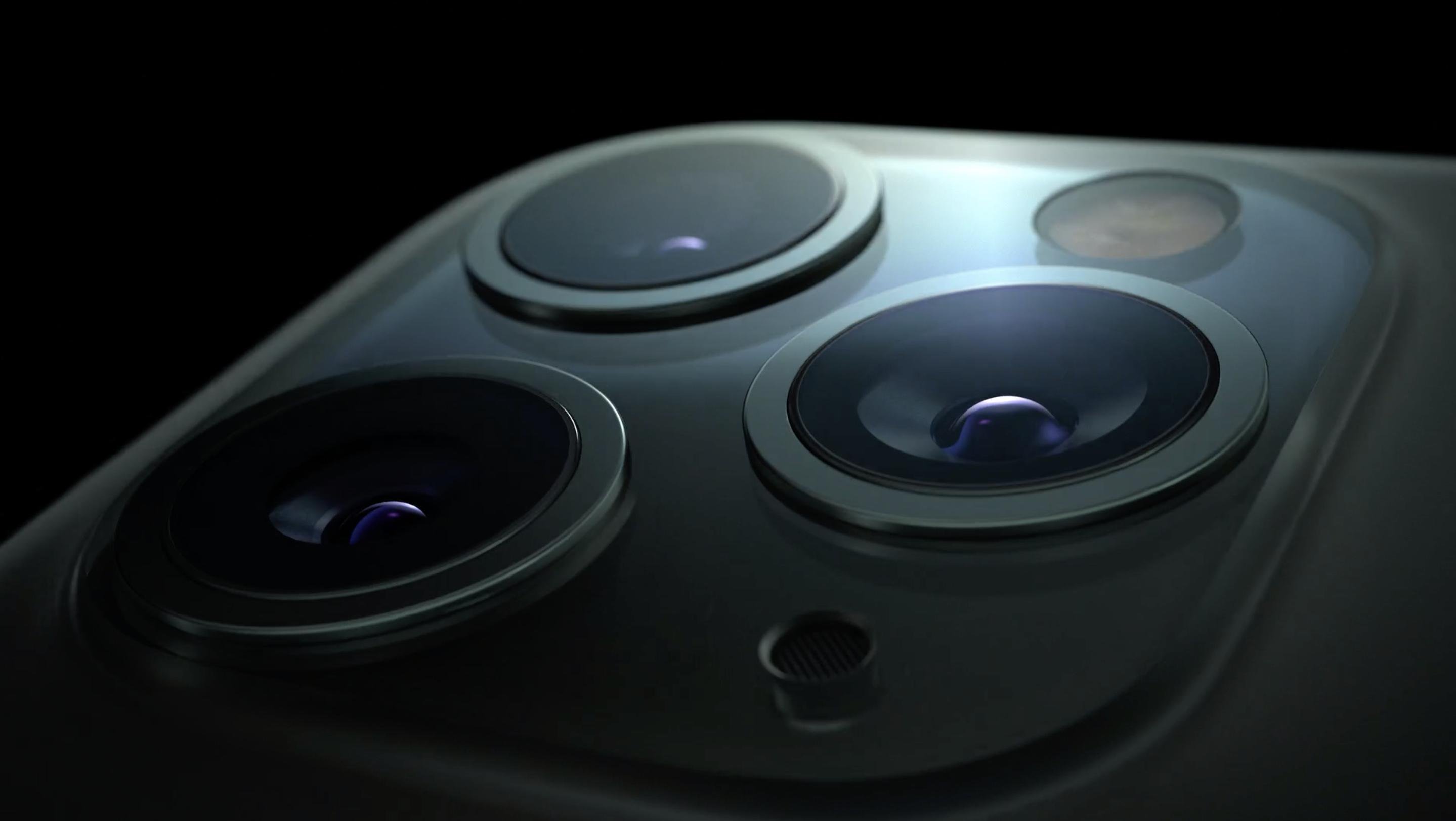

Una de las funcionalidades del iPhone 11, 11 Pro y 11 Pro Max que se mencionaron durante su presentación pero que no quedaron nada claras para casi nadie, es Deep Fusion. Schiller la mencionó y explicó un poco, pero dejó claro que llegaría más adelante al final del año. Parece que ese más adelante será el día que iOS 13.2 sea publicada, en algún momento antes de los días de Navidad.

Según parece, en una versión beta (de pruebas) de iOS 13.2 que está a punto de ser publicada en el portal de desarrolladores, Apple añadirá por fin Deep Fusion al arsenal de trucos que tiene disponibles la App de Cámara de iOS. Nos cuentan eso en The Verge, pero, ¿qué hace exactamente Deep Fusion? – es una buena pregunta porque parece que muy pocos lo tienen claro.

Deep Fusion es simplemente un sistema de análisis y edición de imagen en tiempo real que utiliza machine learning e inteligencia artificial para conseguir mejorar la calidad de imagen de una foto. Las mejoras de calidad que puede conseguir este sistema varían mucho en función de la imagen que se está intentando tomar, pero básicamente se puede decir que el sistema se activa automáticamente en fotos en las que no hay ni mucha luz ni poca luz, en un punto intermedio en el que hay margen para conseguir resultados más nítidos si se analizan y mezclan imágenes que son tomadas incluso antes de que el usuario pulse en el botón de hacer la foto.

Deep Fusion empieza a funcionar cuando el usuario encuadra la escena que quiere fotografiar. Antes de que pulse el botón de hacer la foto, el iPhone ya ha capturado varias imágenes, tres concretamente, y las está analizando lo más rápidamente posible gracias a ese motor neural que tiene el procesador A13, más rápido que el de CPUs anteriores de Apple y de manera totalmente transparente para el usuario. Nada en la pantalla le hace saber que ya se han hecho varias fotos y un sistema las ha analizado en menos tiempo de que tardas en leer estas palabras. Ese análisis busca contenidos desde un punto de vista semántico, de manera que se sabe si en la imagen aparece una mascota, la cara de una persona, o un coche, por ejemplo. Es el mismo sistema que permite buscar por el contenido de una imagen que tengamos en el carrete de fotos. Esto clasifica la imagen y aplica diferentes filtros y procesos que mejoran la imagen en cuanto a definición, claridad, contraste etc pero también se une a otros procesos paralelos que indican al sistema cómo tiene que mezclar esa imagen con otras en las que se han analizado otros aspectos. Todas estas imágenes se toman con una velocidad de obturación elevada para capturar el momento lo más nítido posible, incluso si el sujeto se está moviendo, para poder analizarlas.

Cuando el usuario pulsa el botón del obturador, el sistema toma otras tres imágenes más, por lo que tenemos ya seis exposiciones que se están preparando y procesando mientras el usuario deja de pulsar el botón del obturador y sabe que ha hecho una toma. Entonces, las imágenes tomadas se procesan pixel a pixel con el objetivo de incrementar el detalle, el color de la piel de las personas, se elimina ruido electrónico innecesario… y así un sin fin de ediciones que ocurren, repetimos, de manera automática y transparente para el usuario. Por ejemplo si fotografiamos la cara de una persona, el sistema hará que el pelo de esa persona se vea especialmente contrastado y nítido editando esas variables sólo en esa zona de la imagen, mientras que en otras puede aplicar cierto difuminado y cambiar la temperatura de color ligeramente para que la temperatura de color de la piel tenga un aspecto más natural y realista.

Todo se mezcla en una única imagen real, que es lo que el usuario ve en el carrete de fotos unos segundos después. El objetivo de todo esto es generar imágenes más realistas, con más detalle y con mejoras en iluminación o contraste incluso cuando la situación de la toma original no era la mejor. Este sistema, hace las fotos de todos los usuarios mejores en muchos aspectos, aunque esos usuarios ni siquiera sepan por qué o sepan editar una fotografía correctamente. Es el comienzo de las cámaras machine learning de las que probablemente escuchemos hablar mucho en los próximos años.

Si te preguntas si se puede desactivar Deep Fusion, la respuesta es que no. Apple no parece que ponga un control para poder desactivarlo cuando no se requiere, pero si eso es un problema para ti nuestro consejo es que utilices cualquiera de las Apps de Cámara con controles manuales, y salida de datos en formato RAW. Apps como Halide o Camera+, por ejemplo. Estas no utilizarán los servicios de machine learning del motor neuronal del A13 y por lo tanto tendrán un aspecto más parecido al que se conseguía en modelos de iPhone anteriores.

Estas dos imágenes son ejemplos de fotos hechas con Deep Fusion en un iPhone 11. Las ha provisto Apple a The Verge y puedes pulsar en ellas para descargar una versión en alta resolución, en una nueva solapa.

Si te fijas en los detalles de la piel o de la ropa que llevan estas personas, verás que el nivel de contraste y detalle fotográfico de las fotos, es muy elevado. No hay zonas demasiado expuestas ni sub-expuestas, y no se nota que haya habido un profundo procesado de seis imágenes. Pero ahí está… un sistema de machine learning toma varias fotos y hace una mezcla y edición de las mismas sin que el usuario se entere. El resultado son, simplemente, muy buenas fotos.