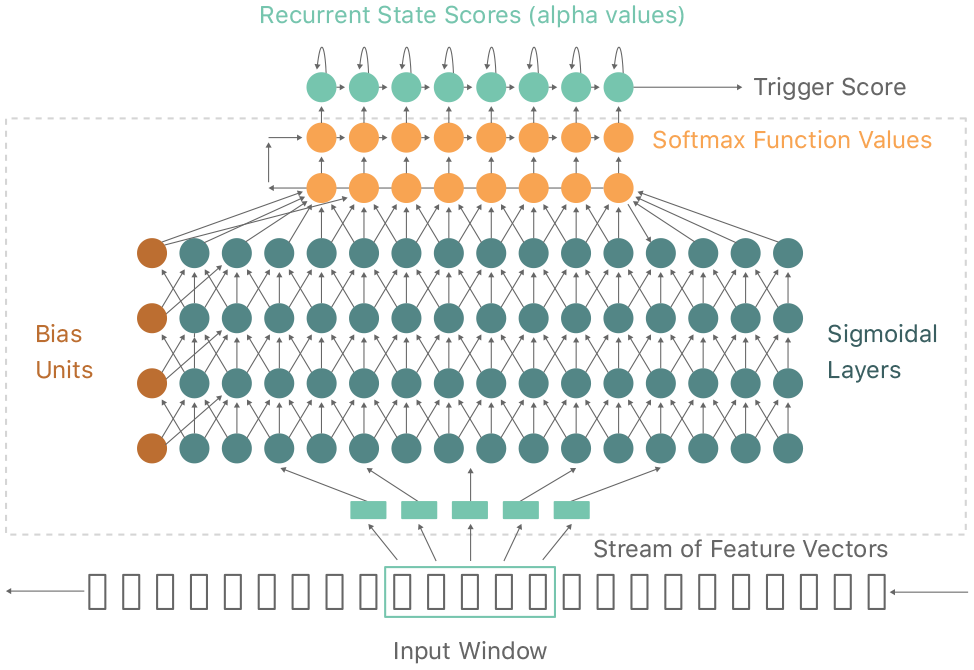

Estamos tan acostumbrados a que cosas como invocar a Siri diciendo “Oye, Siri” en cualquier momento simplemente funcione, que no nos damos cuenta de lo difícil que es conseguir que esa magia funcione. Pero detrás de algo aparentemente tan sencillo, hay todo un sistema de aprendizaje neuronal que hace auténticas maravillas con lo que se escucha en el micrófono del iPhone, en tiempo real, de manera totalmente desapercibida por el usuario.

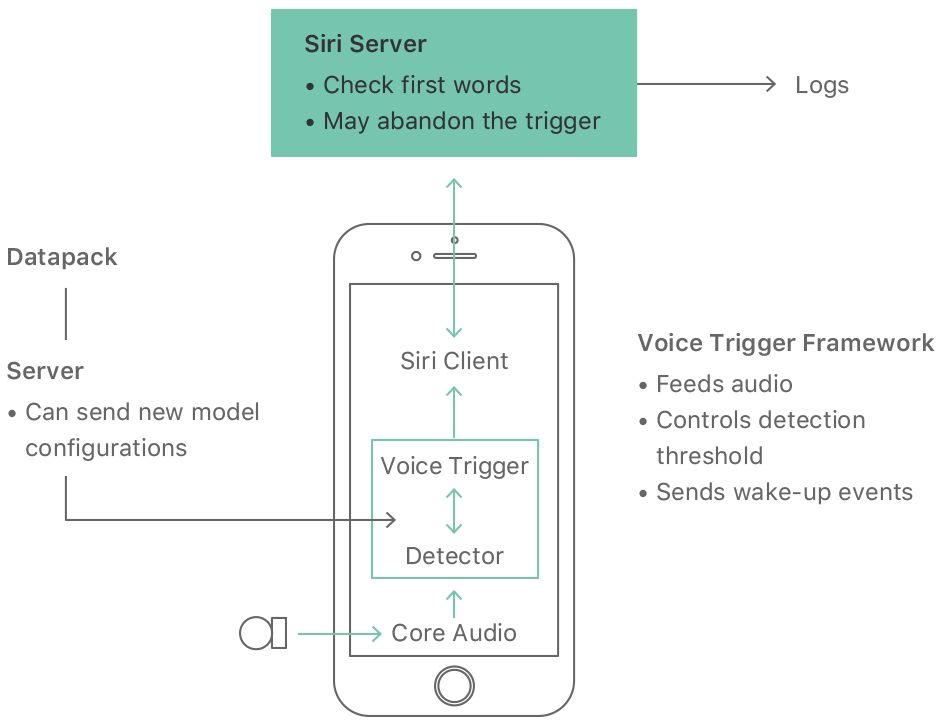

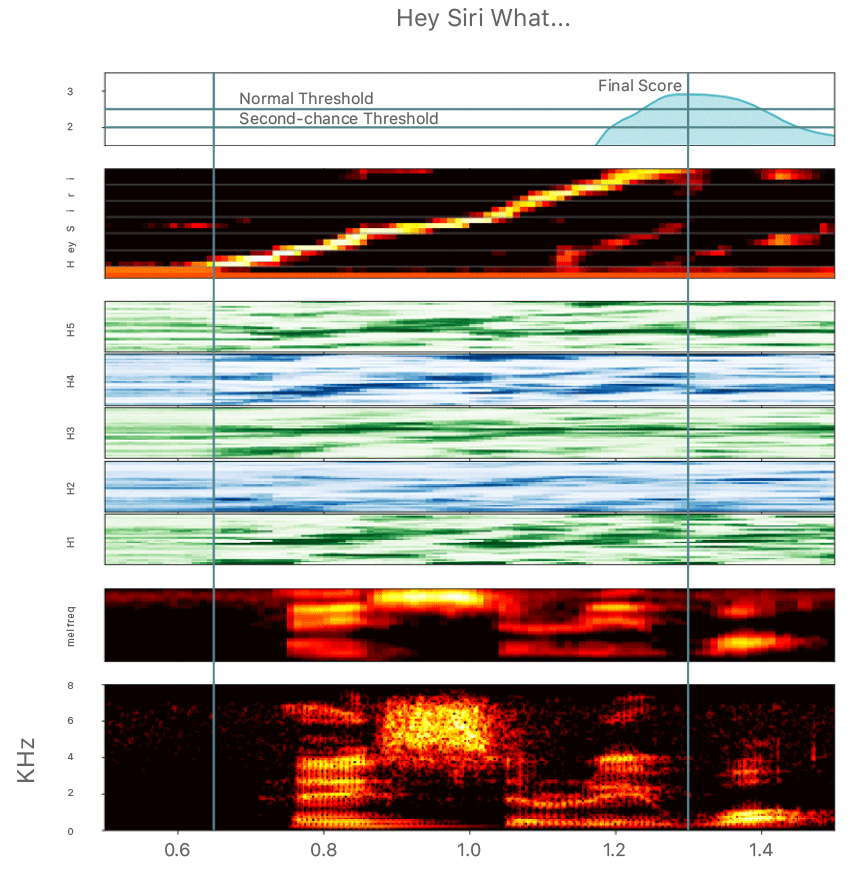

El equipo en Apple que se dedica a desarrollar este tipo de funciones, ha publicado un interesante artículo con todo tipo de detalles que explican cómo consigue iOS determinar cuándo se ha dicho Oye, Siri (Hey, Siri en inglés) y qué hacer cuando se ha percibido algo parecido, como por ejemplo ser más permisivo si se escucha lo mismo una segunda vez inmediatamente después, para darlo como positivo, en casos como alguien que tiene una dicción o acento diferente debido a algún problema de salud, por ejemplo. Hasta este tipo de detalles se piensan y planifican con detalle.

Como vemos en estos gráficos, Oye Siri desencadena un buen montón de procesos increíblemente completos, sólo en una fracción de segundo.

Se tienen en cuenta también parámetros como el consumo energético; Se puede activar o desactivar esta función precisamente por eso, en la App de Ajustes, porque tener el iPhone siempre pendiente de lo que suena alrededor, utilizando sus micrófonos, en busca de ese Oye Siri, hace funcionar la CPU un poco más y eso tiene un impacto en el consumo de energía. Los ingenieros de Apple dedicados a esto, intentan que el procesador no se use en exceso para que ese consumo más elevado de energía apenas se note en la duración de la batería.

Si lees el artículo sin ser un especialista en este tipo de cosas es posible que todo esto te suene a chino, pero en cualquier caso demuestra lo complicado que es conseguir que cualquier cosa que hagamos en nuestro iPhone, funcione bien.