Muchos tenemos curiosidad por saber lo que pueden hacer en Apple con modelos LLM, es decir, modelos lingüísticos de gran tamaño, la tecnología probabilística o modelo de difusión utilizada para hacer funcionar las ahora ubicuas y mal llamadas inteligencias artificiales o IAs. El próximo Siri tiene que estar basado en esta tecnología para convertirse en algo mínimamente útil, y si bien Apple considera modelos LLM de otras compañías, también desarrolla sus propios modelos. Estos son los que queremos ver. Pero, al mismo tiempo, en Apple experimentan con modelos LLM open source intentando conseguir mejores rendimientos a partir de modelos con un conjunto de datos relativamente reducido, ideales para hacer funcionar localmente en dispositivos con menos recursos, como por ejemplo un smartphone.

Cualquiera puede instalar estos modelos open source en su PC o Mac de casa utilizando Ollama por ejemplo, y luego modificar los parámetros con los que funciona para conseguir diferentes resultados de rendimiento. Esto es exactamente lo que han hecho en Apple utilizando Qwen2.5‑7B, un modelo creado por Alibaba en China, disponible públicamente, con 7.000 millones de parámetros (por eso el 7B en su nombre).

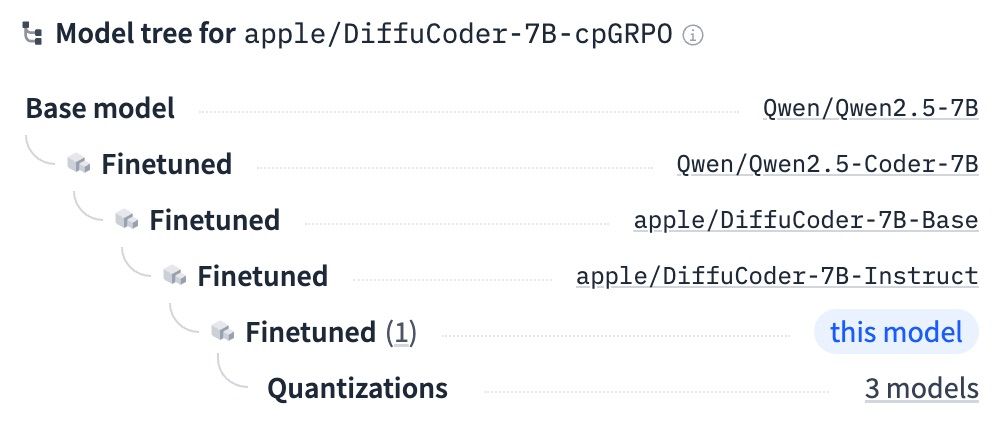

La diferencia, es que los programadores de Apple han modificado este modelo y publicado de vuelts el resultado en Hugging Face, uno de los repositorios de modelos LLM más conocidos. Lo han llamado Qwen2.5‑Coder‑7B, y como puedes ver por el nombre, está especializado en programación de código con una diferencia interesante; Es capaz de generar código funcional sin tener que escribirlo desde la izquierda a derecha y de arriba a abajo como otros modelos, de manera que es capaz literalmente de empezar la casa por el tejado e ir rellenando el resto del programa solicitado, consiguiendo así mejoras de rendimiento que elevan este modelo por encima de lo que se había medido antes.

Esto lo consiguen modificando el parámetro de temperatura, que en modelos LLM define el nivel de flexibilidad o creatividad que se permite al modelo ejecutar desde la petición que se le ha hecho. También han re-entrenado el modelo con ejemplos de código (20.000 en total) elegidos con mucho cuidado de que sean buenos ejemplos de programación de alta calidad.

Aunque es interesante que consigan mejores resultados con Qwen que el resto de la comnunidad dedicada a estas cosas, el nivel de los resultados aún no llega al nivel de GPT-4 de OpenAI ni de Gemini de Google, ahora mismo los modelos más punteros para prácticamente todo. Son los que más destacan siempre en todas las pruebas que se hacen comprobando cientos a parámetros en sus respuestas.

Ver como programadores de Apple modifican y experimentan con modelos de otros es interesante, pero de nuevo, nos gustaría ver cómo funciona un modelo LLM de Apple, pero con una alta probabilidad no vamos a ver uno open source venir de ellos, así que tendremos que esperar a ver si Siri, utilizando algún día un modelo LLM propio de Apple, alcanza un buen nivel de calidad en sus respuestas. Conseguir esto es probablemente una de las mayores prioridades de Apple ahora mismo, porque utilizar un modelo LLM ajeno supone pagar miles de millones de dólares sólo en recursos en centros de datos.