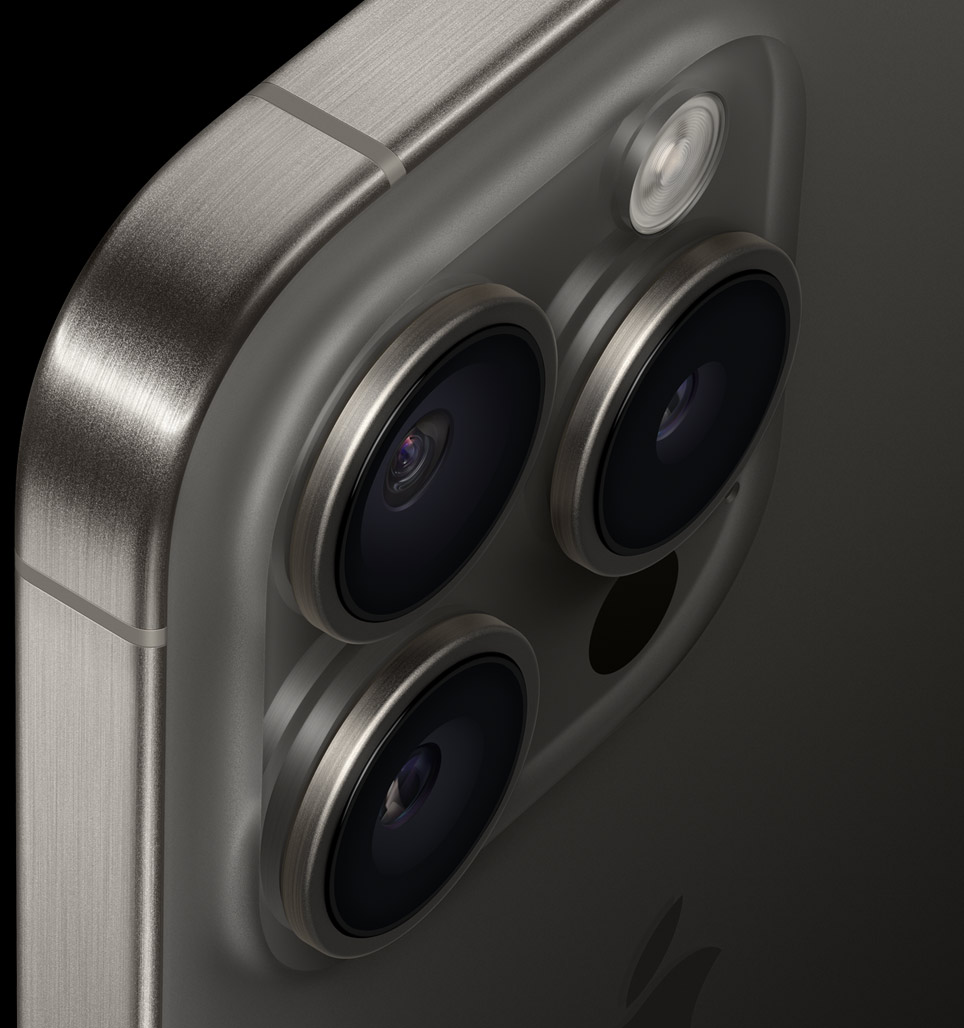

Jon McCormack, máximo responsable del software de la cámara del iPhone en Apple, ha concedido una entrevista a PetaPixel, una web especializada en fotografía. En esa entrevista ha contestado una serie de interesantes preguntas que dan a conocer un poco mejor todo lo que el sistema de cámara del iPhone hace cada vez que uno pulsa en el botón de obturador y hace una foto en el nuevo iPhone 15 o 15 Pro. La mayoría de usuarios no lo saben, pero cuando se pulsa ese botón, se hacen multitud de fotos al mismo tiempo, en diferentes ámbitos, con diferentes exposiciones y sensibilidades, y un complejísimo sistema de tratamiento de imagen elige las mejores tomas, mezcla unas con otras para conseguir exponer partes muy brillantes o muy oscuras uniformemente (HDR), luego aplica diferentes filtros de nitidez, contraste y color, para finalmente darte la imagen que ves casi un instante después en la pantalla de tu iPhone.

Todo este proceso tiene como objetivo conseguir imágenes de alta calidad con un iPhone, y lo consiguen, y aunque a veces para algunos usuarios no es el resultado esperado, en general para la mayoría sí lo es. Es lo que se ha venido a llamar fotografía computacional en los últimos años, con los smartphones a la cabeza porque son las cámaras que todos llevamos encima todo el día.

Apple busca el equilibrio entre ofrecer las funcionalidades más avanzadas posibles, con complejos ajustes, en una cámara que cualquiera puede utilizar sin apenas tener conocimientos de fotografía. El iPhone debe ser una point and shoot, es decir, una cámara que te permita apuntar y hacer la foto sin más, y que de un buen resultado. Al mismo tiempo, el iPhone debe ser (y sobre todo lo es en los modelos Pro) una cámara de la que un fotógrafo experimentado pueda sacar mucho rendimiento, pudiendo alterar prácticamente todos los parámetros de la exposición y trabajar en formato RAW para tener luego más flexibilidad a la hora de editar las fotos en un ordenador o en el propio iPhone. De esto es lo que McCormack habla más en esta entrevista, en conseguir el equilibrio entre ambas formas de usar la cámara del iPhone.

Durante la entrevista nos enteramos de algunos detalles importantes, como por ejemplo que la funcionalidad que permite grabar vídeo externamente a una unidad de almacenamiento vía USB-C sólo funciona con vídeo grabado a resolución 4K, 60 fotogramas por segundo y que utiliza el códec ProRes. La verdad es que no vemos ninguna razón para no permitir por ejemplo grabar a 30 o 24 fotogramas por segundo, o incluso permitir la grabación de vídeo en cualquier otro formato, pero McCormack explica que se trata de una funcionalidad diseñada para el uso profesional de la cámara del iPhone y que por lo tanto sólo se soportan códecs profesionales, como ProRes, sin pérdida de calidad por compresión. No es la respuesta que esperábamos, pero ya sabemos cómo es Apple.

Esperemos a que alguna App de cámara de terceros pueda solucionar estas limitaciones y permitir la grabación de vídeo externa en cualquier formato y resolución, aunque no estamos seguros de si Apple ofrece esta posibilidad a terceros o si se la reserva para sí misma, al menos por ahora.

Por qué fotos a 24 megapixeles en lugar de 12 o 48

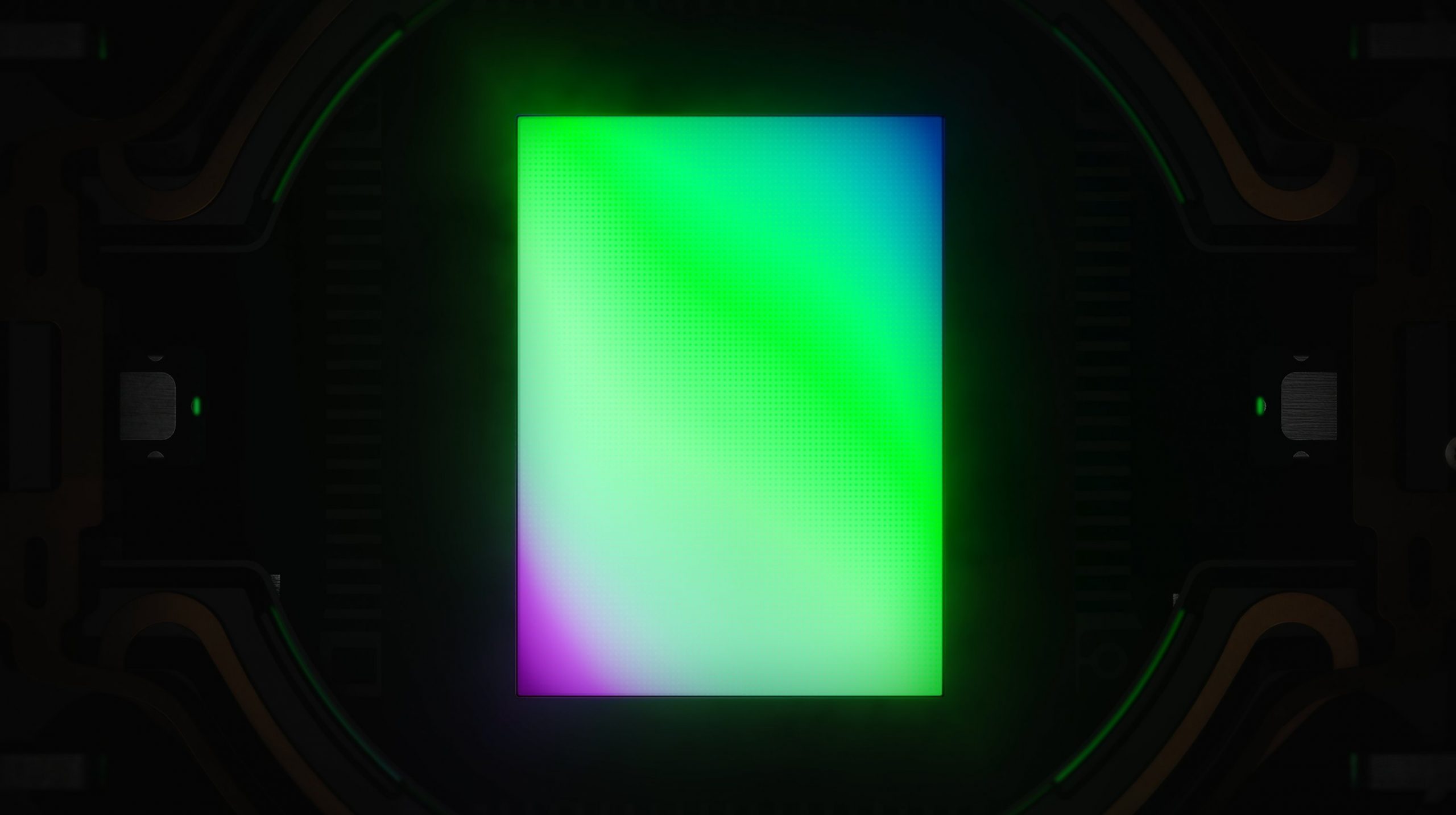

El nuevo sensor de 48 megapixeles, en formato RAW, puede utilizarse a su máxima resolución en condiciones de suficiente iluminación, como en el iPhone 14 Pro, pero no para fotos normales y corrientes, de las que tomamos decenas todos los días. Esas siguen quedándose en los 12 megapixeles. En el caso del iPhone 15 y 15 Pro, es posible elevar la resolución a 24 megapixeles para esas fotos del día a día que no utilizan formato RAW gracias a un equilibro entre las capacidades del sensor. Según McCormack, en 24 megapixeles se consigue el rango dinámico de las resoluciones de 12 megapixeles y la alta resolución de un sensor de 48 megapixeles. Cuando menos resolución se utiliza, más ancho de banda hay para que el sensor pueda enviar la información de múltiples exposiciones en el momento de hacer la foto, ofreciendo más rango dinámico al poder balancear zonas muy brillantes (generalmente el cielo) con otras muy oscuras (generalmente debajo del horizonte). 24 megapixeles permiten conseguir suficientes exposiciones para aplicar esos efectos sin tener que bajar a los 12 megapixeles que antes eran obligados en el iPhone 14 Pro. Esta es la razón por la que sólo se permitía utilizar toda la resolución del sensor cuando se utiliza el modo RAW, porque en ese modo, no se aplica todo ese procesado de imagen en segundo plano.

Si dominas el inglés te recomendamos leer la entrevista entera en PetaPixel.