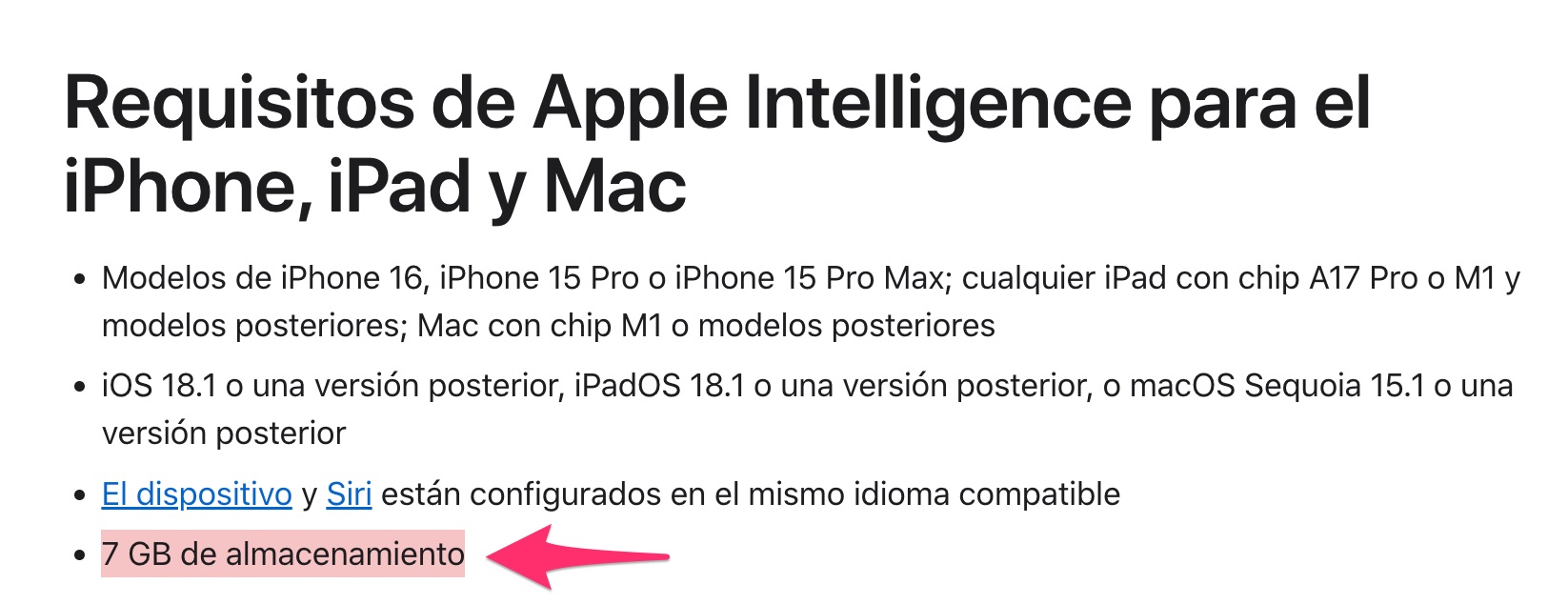

Cuando Apple Intelligence esté disponible en español, en el próximo mes de abril, y cuando podamos utilizarlo en la Unión Europea, debemos preparar 7 GB de almacenamiento en nuestro iPhone, iPad o Mac, porque ese es el espacio que los datos de los modelos LLM de Apple Intelligence que se ejecutan localmente ocupan en nuestros dispositivos.

Apple lo ha publicado en esta página de soporte de su web.

Obviamente es mucho espacio, pero es el precio a pagar por conseguir que este sistema funcione localmente, es decir, sin intervención de ningún servidor online, sin enviar nada a Internet. De hecho, las IAs de Apple Intelligence que funcionan localmente, lo pueden hacer sin conexión a Internet por esa misma razón.

Para que te hagas una idea, ChatGPT requiere siempre ejecutar la consulta en sus servidores, que además son carísimos y utilizan las GPUs de Nvidia más potentes. Por esa razón ahora todo el mundo está sorprendido con el terremoto que ha causado DeekSeek porque además de ser completamente gratis, funciona en servidores mucho más modestos, con GPUs de Nvidia limitadas en potencia que sí pueden utilizar en China (las más potentes las prohíbe EEUU allí) y además de eso se puede instalar en cualquier ordenador, incluso en una Raspberry Pi 5, y funciona, algo que con ChatGPT es simplemente impensable. Probablemente estén un poco preocupados en OpenAI. Pero eso es un asunto para otro artículo.