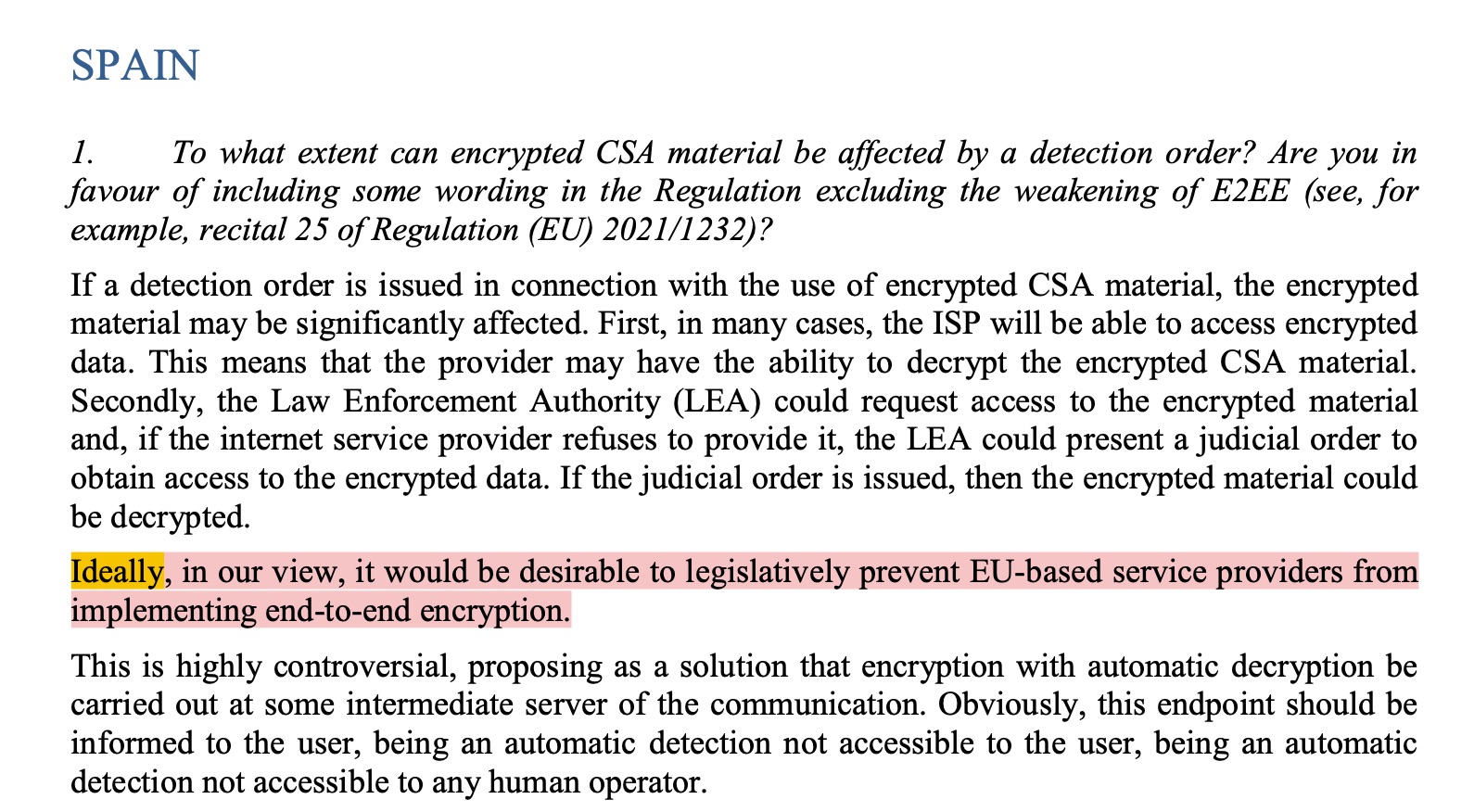

No es agradable ver a España destacar en medios de comunicación extranjeros por algo así. Un documento filtrado que firman los 20 países de la Unión Europea muestra las posiciones de cada país en torno al problema del CSAM, es decir, la detección automática de contenidos deleznables como por ejemplo imágenes o vídeos de abusos a niños. Todos los países quieren hacer algo para frenar o eliminar ese problema, por supuesto, pero entre todos ellos España es el país que tiene una posición más extrema y radical sobre cómo enfrentarse al mismo; prohibiendo el cifrado de datos de punta a punta en todos los servicios.

En el documento el gobierno español indica que esa sería la solución ideal. Para poder utilizar sistemas automáticos de reconocimiento de imágenes que detecten contenidos CSAM, es necesario poder acceder a esos contenidos. Si los contenidos, por ejemplo una foto, están cifrados de manera que sólo el usuario que lo envía y el que lo reciben pueden ver la imagen, es imposible comprobarlos para verificar si efectivamente se trata de una de esas imágenes… ni automáticamente, ni con la intervención de una persona. Simplemente es imposible utilizar esos datos. Las personas que los envían y reciben tienen total protección gracias a ese cifrado. Esto es algo malo, sin duda, pero es precisamente ese cifrado el que garantiza el anonimato de todos los usuarios del servicio, tanto de los pocos degenerados que se envían imágenes de abusos a niños como los de todos los demás usuarios que no lo hacen.

La privacidad funciona así. O la hay para todos, o no la hay para nadie. Esto es precisamente lo que el gobierno de España parece pensar que es ideal, según palabras en ese documento filtrado que puedes comprobar aquí (vía Wired).

En el texto, como puedes leer arriba, indican que podría haber un servidor intermedio que descifre los mensajes entre dos usuarios de manera automática y sin intervención humana si hay un requerimiento de las fuerzas del orden, y si ese es el caso, se informe a los usuarios de que su mensaje ha sido leído.

Esto está escrito obviamente por alguien que no comprende de qué trata todo esto. Simplemente no lo entienden. El cifrado de datos de punta a punta existe y se implementa precisamente para que no exista una llave que permita descifrar el contenido. Ni un servidor intermedio, ni una persona, ni la empresa que ofrece el servicio (por ejemplo WhatsApp) ni el proveedor de Internet, ni nadie excepto la persona que envía la información y la persona que la reciben, pueden descifrar esos datos. El sistema está pensado para que sea técnicamente imposible, al menos con los medios que tenemos hoy en día. ¿Por qué se hace esto así? – es algo totalmente deliberado, y se hace porque, de nuevo, si no hay privacidad para todos, no la hay para nadie. Si existe un sistema de descifrado en algún punto de todo el proceso, será abusado y expuesto por malos actores en el futuro. Sin duda alguna.

Apple presentó un sistema de comprobación automática de imágenes y vídeos que fue rechazado ampliamente. Este sistema funcionaba en el iPhone, antes de que la información se suba a ningún lado, analizando el carrete de imágenes y vídeos, siempre sin enviar ninguna información a ningún lado, y de manera matemática, mediante un algoritmo que comprueba huellas digitales de la imagen con una base de datos de imágenes que se conocen como CSAM. Estaba previsto que una persona interviniera sólo cuando se daban muchos positivos en un dispositivo, descartando así cualquier posible falso negativo, que en cualquier caso sería de nuevo comprobado que es un falso negativo por una persona en cualquier caso. Apple tuvo que dar marcha atrás y cancelar todo el proyecto precisamente por las preocupaciones de la falta de privacidad total.