La tecnología que mueve las ahora erróneamente llamadas Inteligencias Artificiales (IAs para abreviar) se llama en realidad modelo de lenguaje grande o LLM por sus siglas en inglés, aunque a veces se puede encontrar también como modelo masivo de lenguaje o modelo masivo de aprendizaje en Español. Esto es lo que hace funcionar a ChatGPT y compañía, aunque en todos los medios de comunicación generalistas simplemente dicen IAs cuando ni siquiera hay un entendimiento común entre los investigadores más avanzados sobre qué es una IA realmente. Hoy los LLM son noticia en el ecosistema de Apple porque sus investigadores han publicado un paper, es decir, una descripción científica de un avance que han hecho, que describe una herramienta para crear animaciones utilizando peticiones de ChatGPT 3 o 4.

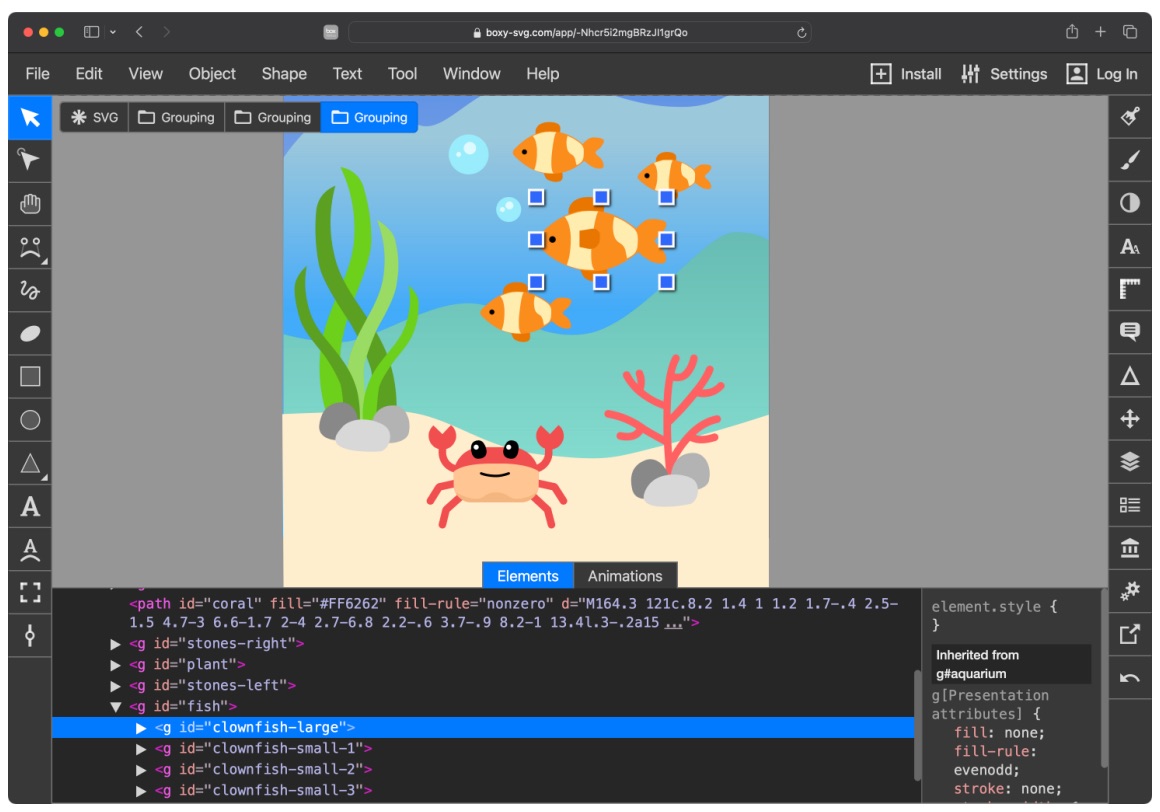

Lo que ves sobre estas palabras es un editor de gráficos vectoriales en una web-App, es decir, una aplicación web que te permite crear, editar y guardar gráficos en formato SVG. Dentro de esa aplicación hacen correr Keyframer, que es el sistema que han creado en Apple para indicarle al programa cómo debe animar un gráfico SVG, dando como resultado un fichero CSS con la animación lista para ser utilizada en cualquier web.

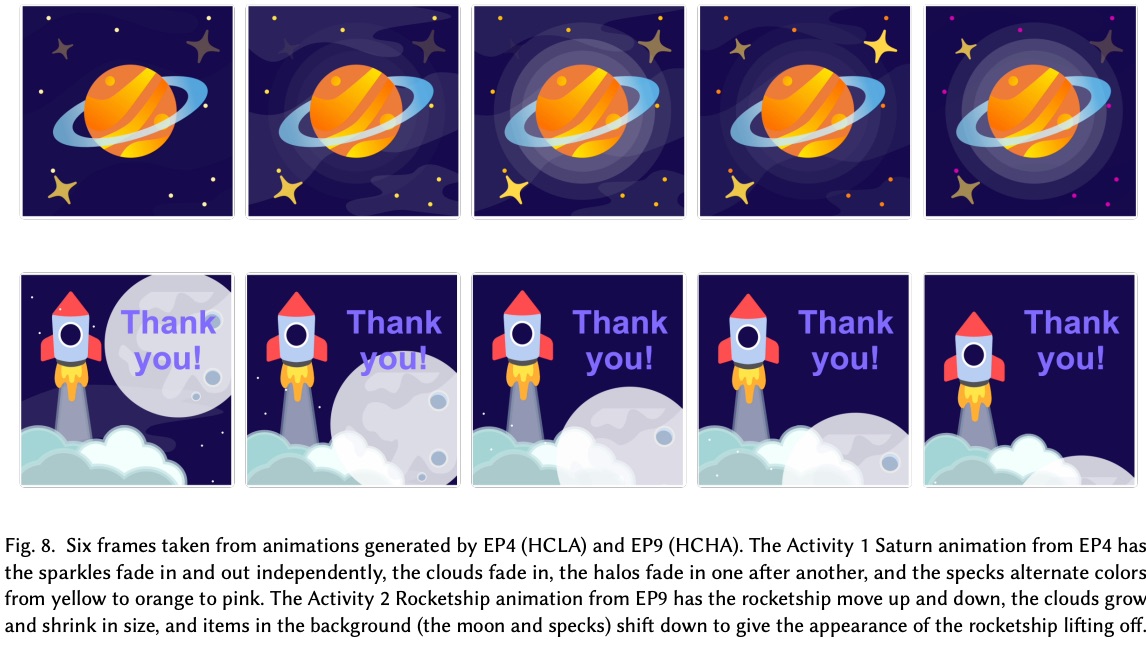

En la imagen de abajo se pueden ver diferentes fotogramas de un planeta en el que piden que brillen las estrellas, y de un cohete que despega. La animación ha sido pedida a ChatGPT, que mediante Keyframer, consigue entregar la animación en formato CSS moviendo esos gráficos SVG provistos.

… ¿y por qué os contamos este rollo? – bueno, la respuesta es que este tipo de investigaciones nos dan un pequeño adelanto de lo que podríamos ver en iOS 18 dentro de unos meses, ya que se especula con que las principales novedades en la nueva versión de este año estarán relacionadas con estos modelos LLM y la inteligencia artificial generativa, es decir, la que permite crear imágenes o, como en este caso, animaciones, simplemente pidiéndoselo en un texto o con nuestra propia voz, nos imaginamos que muy probablemente a través de Siri. La idea es que podamos pedirle que nos cree la imagen de un coche en una carretera y le podamos pedir, por ejemplo, que el coche salga volando por las nubes, creándonos ese vídeo o imágenes de alguna manera. Este tipo de IAs generativas como MidJourney o Stable Diffusion son capaces de generar imágenes con una facilidad espectacular y la idea parece que es conseguir algo parecido directamente integrado en iOS, aunque los detalles, todavía brillan por su ausencia.

Apple aún no ha implementado nada así en iOS pero viendo los papers que publican es probable que estén trabajando en recuperar el tiempo perdido con toda su capacidad, sobre todo ahora que se han quitado de encima el lanzamiento de las Vision Pro, un proyecto que sin duda habrá agotado muchísimos recursos humanos dentro de la empresa.