Si miras bien esta imagen, parece una simple captura de pantalla de un señor disfrutando una videollamada vía FaceTime, ¿verdad? – la verdad, es que en la imagen hay más cosas ocurriendo de lo que podrías pensar, y esto que está ocurriendo es también una de las muchas novedades de las que no se habló durante la presentación de iOS 13.

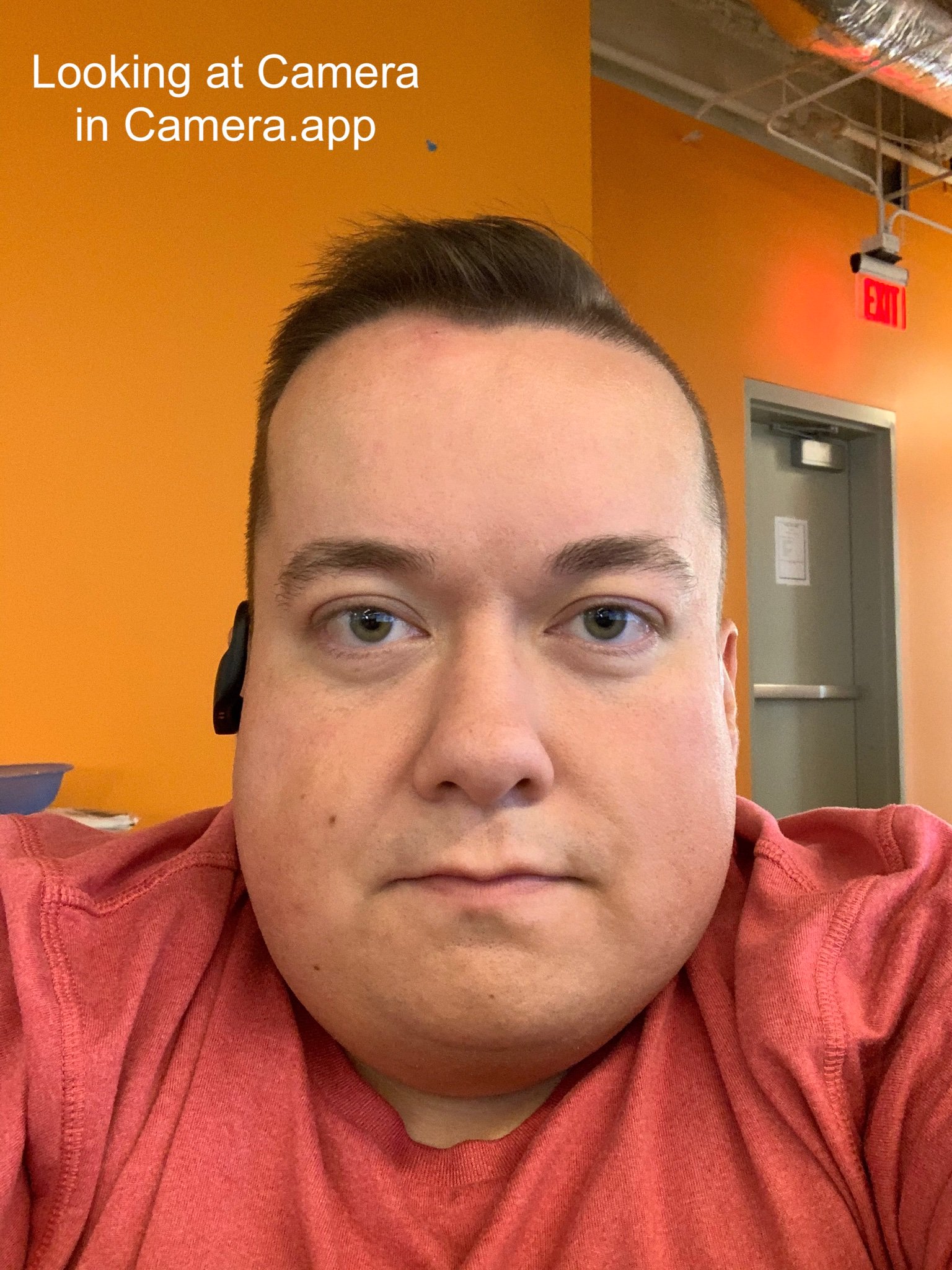

La verdad, es que la cara de esta persona está modificada en tiempo real por un sistema integrado en la App de FaceTime. No se aprecia bien porque el cambio es muy sutil, pero también muy importante. En la imagen, vemos que la persona está mirando a la cámara frontal del iPhone, pero en realidad, no es así. Esa persona está mirando a la pantalla.

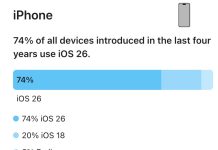

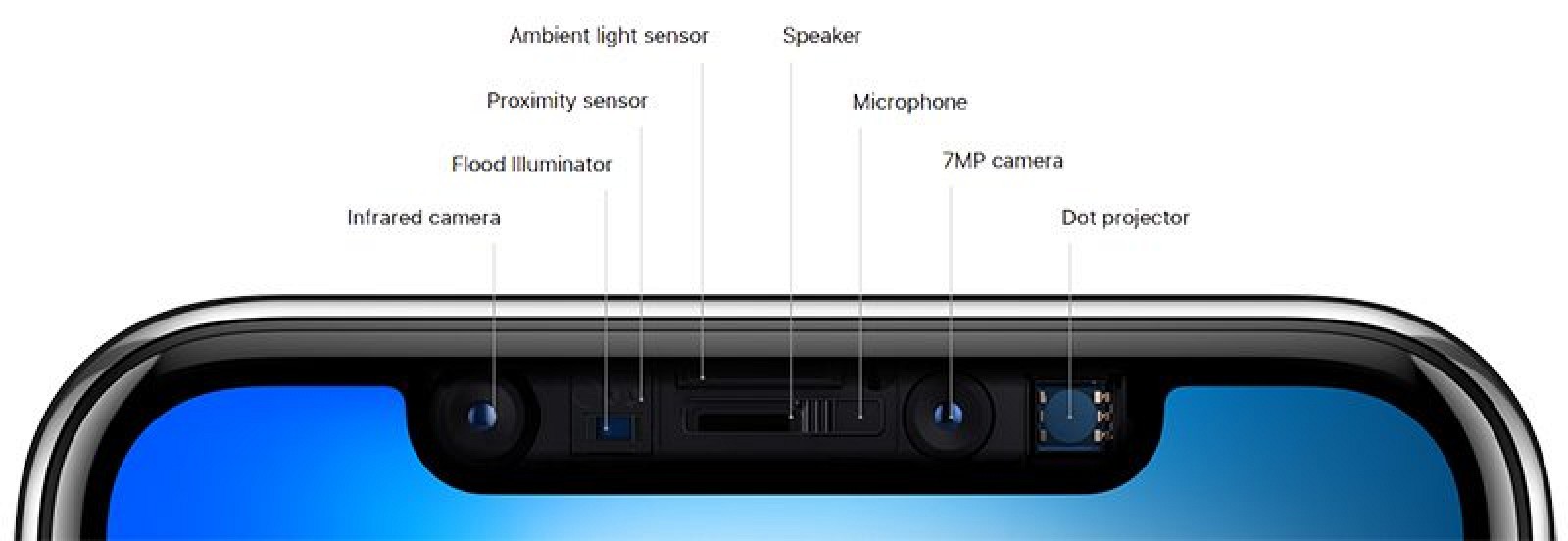

¿Cómo es posible que parezca que mira a la cámara entonces? – como la cámara frontal está en la parte superior de la pantalla, existe un problema a la hora de hacer una videollamada. La persona al otro lado parece que está mirando otra cosa y no hablando con nosotros. Esto ocurre en videollamadas desde cualquier ordenador, tableta o smartphone, independientemente de la marca o sistema operativo que utilice. La razón es simple; La cámara está en la parte superior de la pantalla y esa persona mira un poco más abajo en la pantalla para poder ver la cara de su interlocutor. La diferencia es mínima, pero notable, y a menudo uno no sabe si mirar al a cámara o a tu interlocutor. De hecho, es incluso difícil de ver dónde está la cámara en la pestaña sobre la pantalla del iPhone, en donde hay muchos otros sensores.

iOS 13 soluciona este problema utilizando la librería ARKit (de realidad aumentada) para detectar dónde están los ojos, y utiliza el mapa 3D del rostro de la persona que habla, obtenida con todos esos sensores TrueDepth que ves sobre estas líneas, para saber qué parte de la imagen editar. A partir de ese momento, en tiempo real y sin retraso aparente para la otra persona, iOS 13 edita los ojos para que parezca que miran a la cámara, aunque en realidad, el usuario está mirando más abajo, en la pantalla. Esta es una imagen sin editar de ese mismo usuario mirando a la pantalla.

Esta otra imagen es la imagen sin editar de ese mismo usuario mirando a la cámara frontal del iPhone directamente.

El sistema es espectacularmente efectivo, hasta el punto de no poder darse cuenta que se trata de una imagen editada. Sorprende además que todo esto ocurra en tiempo real sin aviso de ningún tipo. Si quieres detectar que algo pasa ahí, fíjate en este vídeo de un hombre pasando la pata de unas gafas por delante de los ojos. El metal de las gafas se curva ligeramente… esto ocurre porque la imagen está utilizando ese mapa 3D del rostro para editar la parte de los ojos, y la pata de las gafas adopta la curvatura del globo ocular que iOS 13 utiliza en ese modelo en tres dimensiones.

How iOS 13 FaceTime Attention Correction works: it simply uses ARKit to grab a depth map/position of your face, and adjusts the eyes accordingly.

Notice the warping of the line across both the eyes and nose. pic.twitter.com/U7PMa4oNGN

— Dave Schukin 🤘 (@schukin) July 3, 2019

Realmente impresionante… magia de la casa, muy típica de Apple. Es un uso de realidad aumentada en el que nadie había pensado hasta ahora.